Blog

Retour aux articlesTest A/B : n’arrêtez pas avant d’avoir assez attendu

Partager

Catégories

Test A/B : n’arrêtez pas avant d’avoir assez attendu

Une des grandes questions que se posent nos clients lorsqu’ils font appel à nous est : “Quand est-ce qu’un test A/B ou multivarié doit s’arrêter ?” OU “A partir de quel moment est-on sûr d’être sûr du résultat ?”

Questions simples, mais réponses compliquées !

Première remarque : il est, la plupart du temps, malvenu d’arrêter un test en cours si ses résultats sont négatifs ou supposés négatifs. Mais c’est une réaction normale que l’on peut comprendre : voir la courbe d’un test s’effondrer peut signifier (en e-commerce) une perte de chiffre d’affaires. Grande est dès lors la tentation de stopper le test ou de le modifier et de passer à un autre test.

Première leçon : ne pas se fier aux apparences

C’est d’après moi une erreur.

Ou du moins, une erreur, tant que la question n’a pas été plus approfondie. Pour cela, il est indispensable de se pencher plus en avant sur les données dont on dispose. Je le montrerai à travers un exemple d’un test sur un site dont je ne peux citer le nom, mais qui prouve bien, cependant, qu’il faut savoir attendre, et pas seulement pour des raisons statistiques.

L’indice de confiance des logiciels de tests est intéressant dans la mesure où il donne une vue mathématique d’une expérience en cours. En gros, il considère qu’à partir d’un certain volume de données, le résultat peut être considéré comme fiable. L’inconvénient, ou en tout cas, l’erreur, serait de croire qu’il serait entièrement fiable d’un point de vue commercial, et cela pour une bonne raison : l’indice de confiance si le test n’est pas suffisamment calibré ne peut pas prendre en compte les différences intrinsèques du trafic testé.

Je m’explique. Dans le test dont je parle, le trafic n’était pas suffisant pour mettre en place un test multivarié alors que beaucoup d’éléments devaient être testés. Je me suis donc rabattu sur un test A/B en privilégiant une hypothèse précise. Il me fallait prendre tout le trafic possible pour obtenir suffisamment vite le résultat de mon test. Le but d’un test n’est pas, n’est-ce pas, de durer plusieurs mois.

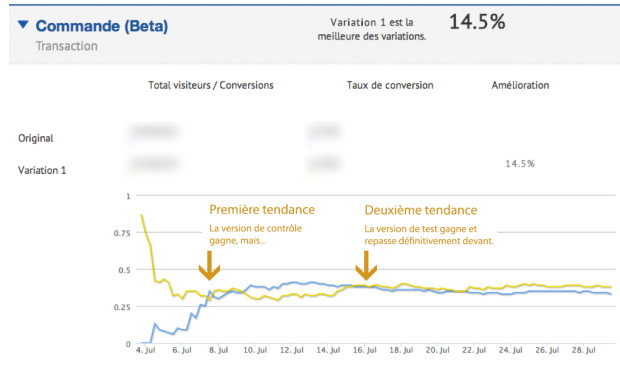

Au bout de quelques jours, comme vous pouvez le voir sur la courbe ci-dessus, la version gagnante semblait être la version de contrôle (et non pas la version de test). Mais en y regardant de plus près et en croisant les données avec Google Analytics, je me suis aperçu qu’il y avait beaucoup plus de visiteurs anciens dans le trafic de la nouvelle version que de visiteurs nouveaux, introduisant par là un biais dans le résultat. En effet, qui dit “plus de visiteurs anciens” dit plus de résistance au changement et donc propension à moins convertir. J’appelle ça l’effet d’accoutumance. Et malgré un indice de confiance suffisant de la part du logiciel de test, il fallait donc attendre que le trafic s’équilibre entre visiteurs anciens vs nouveaux.

Et effectivement, au bout de quelques jours, la tendance s’inversait définitivement au profit de la version B (la nouvelle version donc). Il me suffisait alors ensuite de contrôler à nouveau la répartition du trafic entre anciens et nouveaux visiteurs pour être certain de mon résultat.

Donc en cas d’un constat de moindres performances sur les variations testées, ne paniquez pas. Vous risquez d’arrêter le test trop tôt, de tirer des conclusions hâtives et de ne pas retirer les bénéfices de la version gagnante. Demandez-vous d’abord si le trafic impliqué dans le test est correctement distribué entre les versions. Regardez si les répartitions suivantes sont quasi-égales selon les variations : nouveaux visiteurs / anciens visiteurs, sources d’acquisition, résolution d’écran, navigateurs, dispositifs utilisés (ordinateurs, tablette, mobile), visites des pages promotions, utilisation du moteur de recherche, etc.

Deuxième leçon : toujours aller plus loin

Ceci étant dit, il me semble également très important d’ajouter qu’un test ne doit pas être regardé qu’à l’aune de son objectif principal.

Dans le cas précédent, il s’agissait de tester une fiche produit. Les indicateurs intéressants pour la fiche produit sont souvent le taux d’ajout au panier, puis, ensuite le taux de conversion et la valeur par visiteur. Cela permet de voir, si effectivement, une amélioration de la performance de la page a lieu.

Sans pouvoir vous dévoiler la maquette, voici les modifications auxquelles nous avions procédées.

- Augmentation de la visibilité des éléments de rassurance sous le bouton “Ajouter au panier”

- Amélioration de la visibilité du nom du produit

- Amélioration de la visibilité du stock

- Amélioration de la visibilité du prix

Ces quatres éléments, vous le constaterez avec moi, tendent vers une meilleure rassurance et une meilleure information sur la fiche produit. Ce sont des facteurs extrêmement important pour augmenter la conversion.

Les résultats à la fin du test ont été probants :

+ 14 % en taux de transfo et ce, malgré une baisse de 1,4% du taux d’ajout au panier

Que s’est-il passé ?

Premier point : malgré une baisse du taux d’ajout au panier, on constate une augmentation de 9% de la validation du panier pour les personnes ayant vu la nouvelle fiche produit.

Deuxième point : on discerne très nettement dans le trafic des visiteurs ayant la version de test une augmentation des visites vers les pages de rassurance (+15% environ). Effet indirect ou induit, ces mêmes testeurs vont moins solliciter la page de contact.

Troisième point : une meilleure information entraîne un meilleur engagement des visiteurs avec une très nette augmentation de pages vues par visites, ainsi qu’un taux de retour (de visite) en augmentation également.

Comme vous pouvez le voir, ce test simple nous a permis d’en apprendre beaucoup sur le comportement des utilisateurs et nous a permis de découvrir de nouvelles pistes d’optimisation : amélioration des informations sur les pages produits et services notamment.

Il nous a aussi montré qu’il n’est pas possible de ne pas attendre suffisamment longtemps la conduite du test, car trop d’éléments humains entrent en jeu pour se contenter d’un résultat obtenu en moins de 2 semaines.

Tester consiste donc à bien mesurer les effets de bord et à être patient.